블로그

-

INSIGHT

AI트렌드에 개념더하기: 소형언어모델 (SLM)

2024.03.22.

-

AI산업과 관련해 자주 언급되는 대규모언어모델(Large Language Model, LLM)은 “데이터를 기반으로 학습되어, 콘텐츠를 인식하고 요약, 번역, 예측, 생성할 수 있는 인공지능 모델”입니다. 이는 생성형 AI 서비스에 접목되어, 많은 분야에서 업무 생산성을 높이고 있습니다.

그러나, 이러한 LLM은 대량의 데이터를 기반으로 학습될 뿐 아니라, 사용 과정에서도 규모의 컴퓨팅 자원을 필요로 하는데요. 이에 최근에는, 더 작은 양의 데이터를 바탕으로 학습하면서도, 대규모언어모델과 같은 수준의 퍼포먼스를 보일 수 있는 AI개발 방법론에 대한 연구가 이어지고 있습니다.

1. 소형언어모델

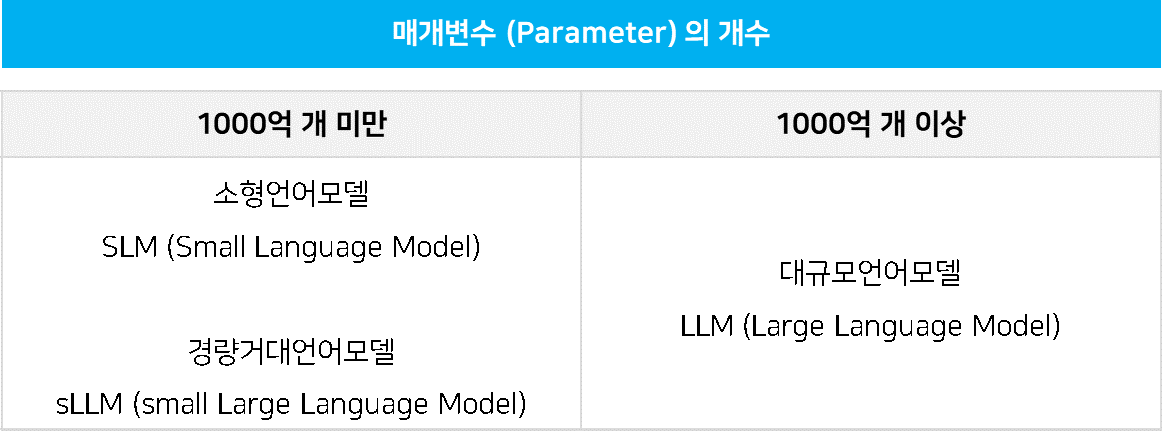

소형언어모델이란, 말 그대로 대규모언어모델에 비해 크기가 작은 언어 모델을 말합니다. 언어모델은 통상 “매개변수” 개수에 따라 크기가 결정되는데요.

[사진1] 매개변수 개수에 따른 언어모델구분

LLM의 경우, 일반적으로 1000억개 이상의 매개변수로 구성됩니다. 대표적으로, 챗GPT에 적용된 'GPT-3'의 매개변수는 1750억 개이며, 구글이 개발한 '팜(PaLM)'은 5400억 개에 이른다고 합니다.

“매개변수 / Parameter”

“매개변수”란, 사람의 뇌에서 “시냅스”와 같은 역할을 합니다. 시냅스는 뉴런이나 세포들과 접촉해 정보가 오고 가는 신경회로망을 구성합니다. 인공신경망에 대해 자세히 다루었던 지난 포스트를 참고하자면, 이는 언어모델이 학습하는 동안 조정되는 가중치(W)와 편향(b)을 말합니다.

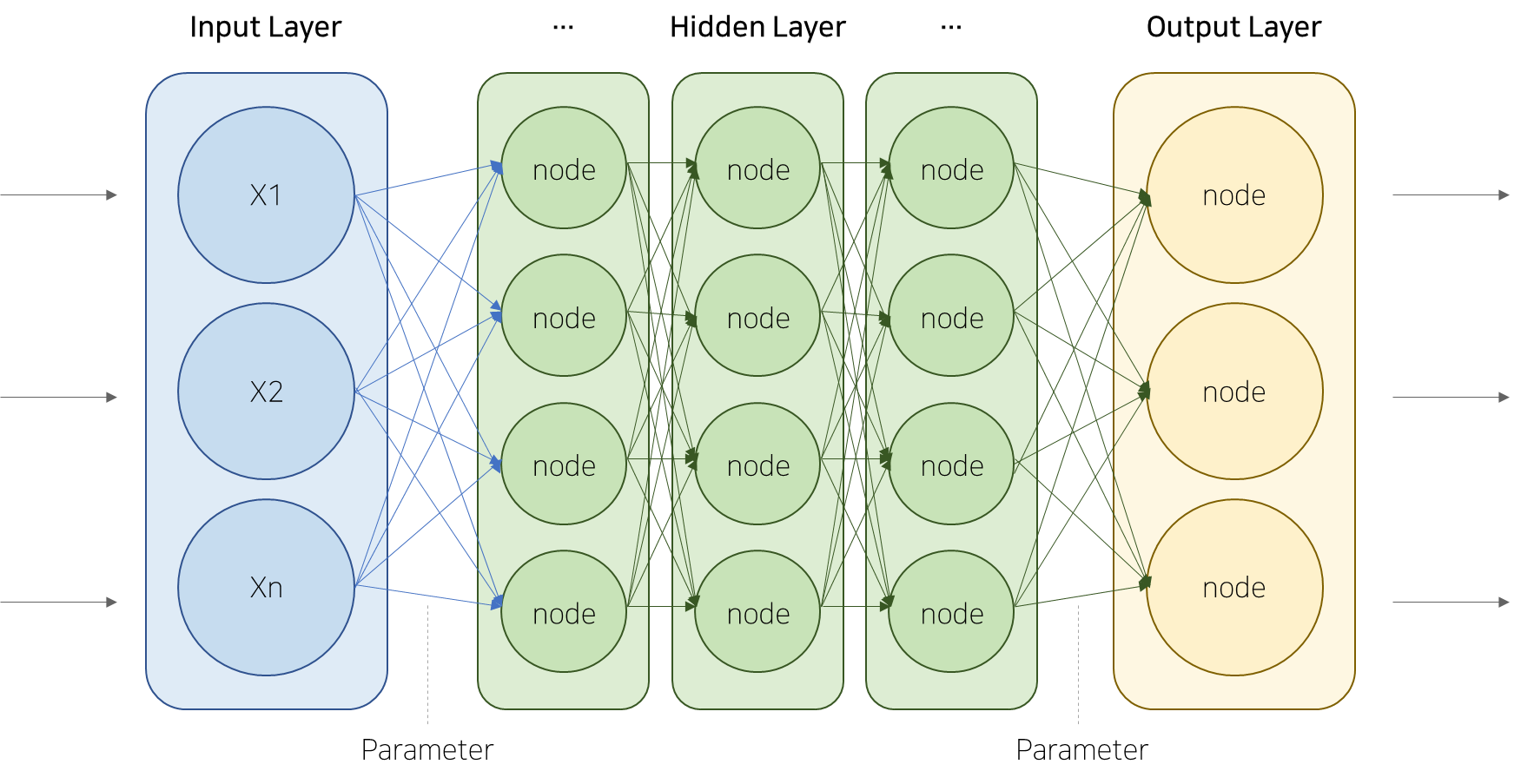

[사진2] 인공신경망 모델

언어모델 속 데이터를 처리하는 여러 층은 매개변수로 연결되어 있습니다.

매개변수가 많을수록 언어모델은 더 복잡한 패턴을 학습할 수 있지만, 그만큼 학습과정이 더 많은 계산 자원과 시간을 필요로 합니다. 따라서, 대규모언어모델에 비해 적은 수의 매개변수로 구성된 소형언어모델은 더 적은 자원으로 작동하되 그만큼 성능 또한 떨어질 것이라고 생각되죠.

그러나, 매개변수 개수는 줄이되, 미세조정(fine-tuning)과 고품질의 데이터 학습을 통해 특정 분야에서는 LLM에 맞먹는 성능을 보여주는 소형언어모델이 최근 주목받고 있습니다.

| 데이터브릭스, “돌리 2.0” (2023.04)

우리는 ChatGPT와 같은 인간 상호작용 역량을 지닌 LLM, 돌리를 30달러도 안되는 돈으로 훈련해 배포했습니다.

출처: 데이터브릭스돌리 2.0은 글로벌 오픈소스 커뮤니티 엘류서AI(EleutherAI)가 배포한 120억 매개변수의 ‘파이티아(Pythia)’ 오픈소스 언어 모델과 ‘데이터브릭스-돌리-15k(databricks-dolly-15k)’ 데이터셋을 기반으로 개발됐습니다.

돌리 2.0은 모델과 훈련 데이터가 모두 오픈 소스에 해당하기 때문에 이를 상업적으로 활용할 수 있다는 점에서 이전의 언어모델들과 차별화되는데요. 알리 고지(Ali Ghodsi), 데이터브릭스의 CEO는 기업들이 자체 데이터셋을 통해 돌리 2.0을 훈련시킴으로써, 적은 비용으로 니즈에 맞는 맞춤 언어모델을 사용할 수 있을 것으로 기대했습니다.

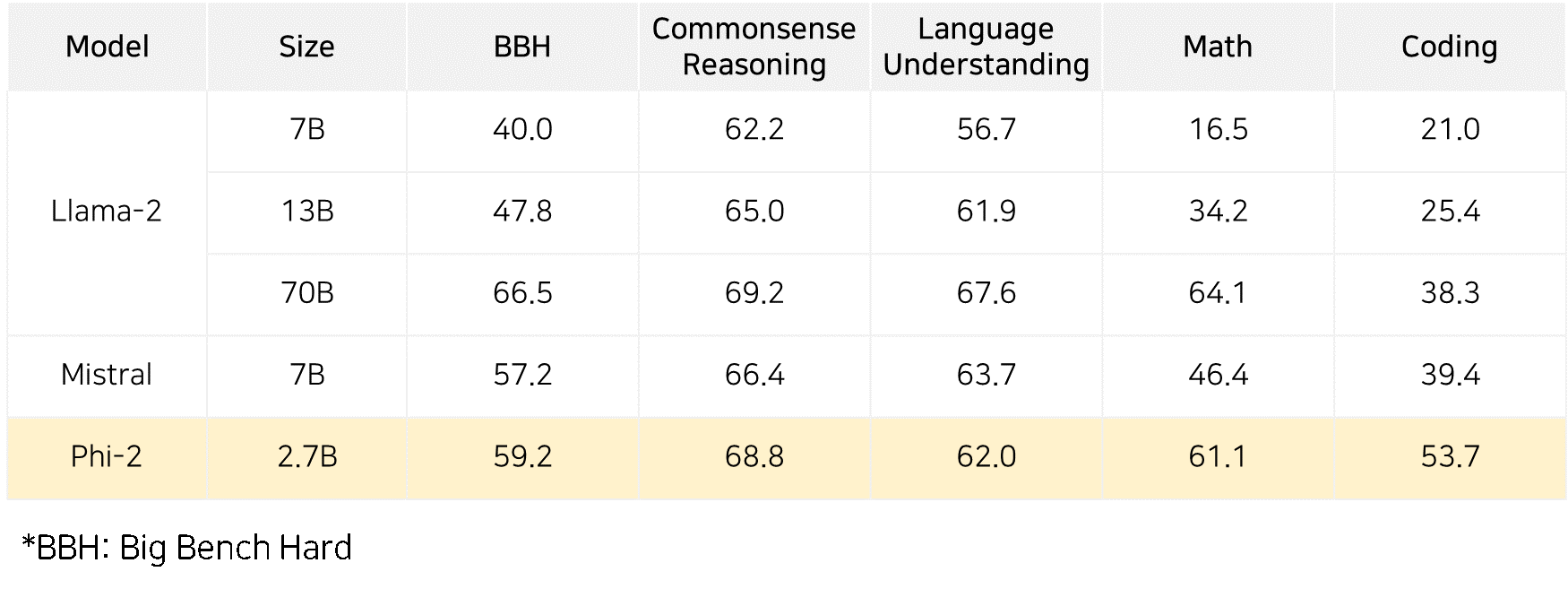

| 마이크로소프트, Phi-2 (2023.12)

저희는 이제 뛰어난 추론과 언어 이해 능력을 보여주는 27억 매개변수 언어 모델인 Phi-2를 출시하여

130억 매개변수 미만의 기본 언어 모델 중에서 최첨단 성능을 보여줍니다.

출처: 마이크로소프트

[사진3] Phi-2 성능 비교(1) (출처: 마이크로소프트)마이크로소프트는 학술적 기준에 따라 Phi-2의 성능을 평가한 결과, Phi-2는 Mistral 및 Llama-2 모델 (각각 70억 및 130억 매개변수 기반)을 능가하며, 특히 700억 매개변수를 기반으로 하는 메타의 Llama-2-70B 모델에 비해 코딩 및 수학과 같은 다단계 추론 작업에서 더 뛰어난 성능을 보인다고 밝혔습니다.

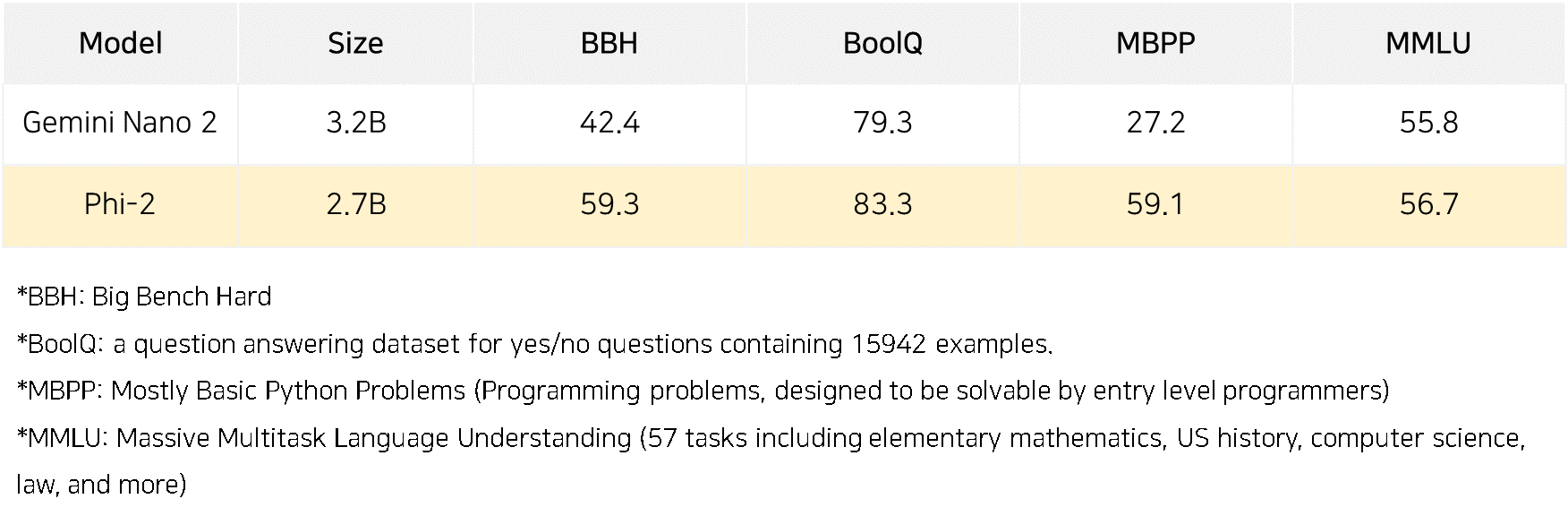

[사진4] Phi-2 성능 비교(2) (출처: 마이크로소프트)마이크로소프트는 Phi-2가 구글의 Gemini Nano 2에 비해서도 우수한 결과를 달성했다고 밝혔는데요. 구글의 Gemini Nano는 Gemini 중 가장 작은 사이즈로 제공되는 모델로, 스마트폰과 같은 기기에 탑재될 수 있도록 설계되었습니다. Phi-2가 이러한 모델보다 더 작고, 좋은 성능을 보인다는 건, 온디바이스에서 활용할 수 있는 언어모델로서도 가치가 높다는 것을 보여줍니다.

| 업스테이지, 솔라 (2023.12.14)

업스테이지는 14일 세계 최대 머신러닝 플랫폼 허깅페이스에서 운영하는

‘오픈 LLM 리더보드’에서세계 1위를 차지한 사전학습 LLM 솔라를 공개했다고 밝혔다.

출처: 업스테이지

국내 기업 또한 글로벌 언어 모델 시장에 도전장을 내밀고 있습니다. 업스테이지는 작년 12월, 소형언어모델 솔라(Solar, Specialized and Optimized Llm and Applications with Reliability)를 공개하며, “소형언어모델의 기준이라고 할 수 있는 300억 매개변수(30B) 이하 사이즈”로 허깅페이스의 ‘오픈 LLM 리더보드’에서 세계 1위를 차지하기도 했습니다.

2. 온디바이스 AI와 소형언어모델

소형언어모델은 최근 주목받고 있는 온디바이스AI 트렌드와 맞닿아 있습니다.

소형언어모델은 적은 양의 컴퓨팅 자원을 필요로 하기 때문에, 스마트폰과 같은 크기가 작고 가벼운 디바이스에서도 최대한의 퍼포먼스를 갖춘 인공지능을 구현합니다.

[사진5] 갤럭시 S24 (출처: 삼성닷컴)올해 초, 첫 AI 폰으로 역대 갤럭시 S 시리즈 중 사전 예약 판매 신기록(약 121만대)을 기록한 삼성전자는, “온디바이스 AI 폰 구현의 비결”이 “LLM 경량화”에 있다고 말했는데요. 이를 기반으로, 개인맞춤형 디바이스의 보급에 한 발 더 다가설 수 있을 것으로 보입니다.

[사진6] 업스테이지 로고앞서 살펴본, 업스테이지의 SLM 솔라는 LG전자와의 협업을 통해 온디바이스 AI 보급을 가속화할 것으로 보입니다.

업스테이지는 LG전자와 ‘AI사업 분야 제휴 양해각서’를 체결하며, LG 노트북 그램을 비롯한 PC 및가전에 활용할 수 있는 온디바이스AI 기반 경량화 언어모델을 개발할 예정입니다.

3. 소형언어모델의 가치

지금까지 소형언어모델의 개념과 활용 가능성에 대해서 간단히 살펴보았는데요. 소형언어모델이 가져올 수 있는 활용가치를 정리해보면 다음과 같습니다.

(1) 성능과 효율성

소형 언어모델은 적은 파라미터로 뛰어난 성능을 제공하여 자원 효율성을 극대화합니다.(2) 온디바이스 AI 적합성

작은 모델 크기는 디바이스 내에서의 AI 실행을 간소화하며, 높은 효율성과 빠른 응답을 제공합니다. 이를 기반으로, 소형언어모델은 휴대폰, 스마트 스피커, IoT 디바이스 등 다양한 플랫폼에서 활용 가능하며, 새로운 비즈니스 기회를 창출할 수 있습니다.(3) 보안 및 개인정보 보호

사용자 데이터를 로컬에서 처리하는 소형 언어모델은 클라우드 전송 없이 보안 및 개인정보 보호를 강화할 수 있습니다.이러한 이점들로 미루어 볼 때, 소형언어모델은 온디바이스 AI 보급을 가속화하고, 사용자에게 혁신적인 서비스를 제공할 기술력의 핵심으로 앞으로도 계속해서 성장할 것으로 전망됩니다.

-

Reference

Lucas Mearian, Computerworld, ““다음 단어 예측 엔진” LLM 알고리즘의 이해”

https://www.itworld.co.kr/news/325660“생성형 AI, 이제는 성능 싸움이다! LLM(거대언어모델)의 모든 것”

https://news.lginnotek.com/1387“Scaling Laws of Large Language Models: Parameters vs Tokens”

https://www.linkedin.com/pulse/scaling-laws-large-language-models-parameters-vs-tokens-jatasra-p0ogf/Free Dolly: Introducing the World's First Truly Open Instruction-Tuned LLM

https://www.databricks.com/blog/2023/04/12/dolly-first-open-commercially-viable-instruction-tuned-llmPhi-2: The surprising power of small language models

https://www.microsoft.com/en-us/research/blog/phi-2-the-surprising-power-of-small-language-models/임대준 기자, AI타임스 (2023.04.03), “슈퍼컴 필요없는 소형 언어모델 'sLLM' 급부상”

https://www.aitimes.com/news/articleView.html?idxno=150299뉴스핌 (2024.01.21), “[갤럭시 언팩] "온디바이스 AI 폰 구현 해낸 비결은 'LLM 경량화'"”

https://www.newspim.com/news/view/20240119000974오규진 기자, 연합뉴스 (2024.01.26), “'역대급 흥행' 갤럭시 S24, 사전예약 개통 기간 8일 연장”

https://www.yna.co.kr/view/AKR20240126145400017업스테이지-LG전자, 온디바이스AI 시장 개척 나선다

https://www.content.upstage.ai/newsroom/upstage-lg-ondeviceai