블로그

-

INSIGHT

AI트렌드에 개념더하기: LLM부터 LMM까지

2024.01.19.

-

2024년 기술 경쟁의 핵심은 AI(Artificial Intelligence)임이 공고해 보입니다.

올해 CES에서는 일반 가전, 모빌리티, 모바일 디바이스 등을 통해 AI가 일상에 완전히 녹아들 수 있음을 증명했고, 가트너는 2026년까지 생성형 AI 모델을 사용할 기업 비율이 80%에 달할 것으로 예측했습니다.

AI의 역량이 기존에 인간만 할 수 있다고 여겨지던 일의 영역을 뛰어넘으면서, 인간 사용자의 역할은 AI를 운영하고 그 외의 가치에 주목하는 것으로 이동할 것으로 보이는데요.

AI에 대해 더 잘 알아야만, AI를 잘 활용할 수 있겠죠.

오늘은 AI와 함께 빈번히 등장하는 LLM(Large Language Model, 대형언어모델)에 대해 살펴봄으로써, AI에 대한 이해도를 높여보고자 합니다.

1. LLM이란?

AWS : 방대한 양의 데이터를 기반으로 사전 학습된 초대형 딥 러닝 모델

CLOUDFLARE : 인간의 언어나 기타 복잡한 데이터를 인식하고 해석할 수 있을 만큼 충분한 예제를 제공받은 컴퓨터 프로그램

NVIDIA : 대규모 데이터 세트에서 얻은 지식을 기반으로 텍스트와 다양한 콘텐츠를 인식하고 요약, 번역, 예측, 생성할 수 있는 딥 러닝 알고리즘

종합하면, LLM은 “데이터를 기반으로 학습되어, 콘텐츠를 인식하고 요약, 번역, 예측, 생성할 수 있는 인공지능 모델”이라고 볼 수 있는데요.

그렇다면, 모든 AI은 LLM이라고 부를 수 있는지, 생성형 AI(Generative AI, Gen AI)와는 어떤 차이가 있는지, 오늘 콘텐츠를 통해 살펴보겠습니다.

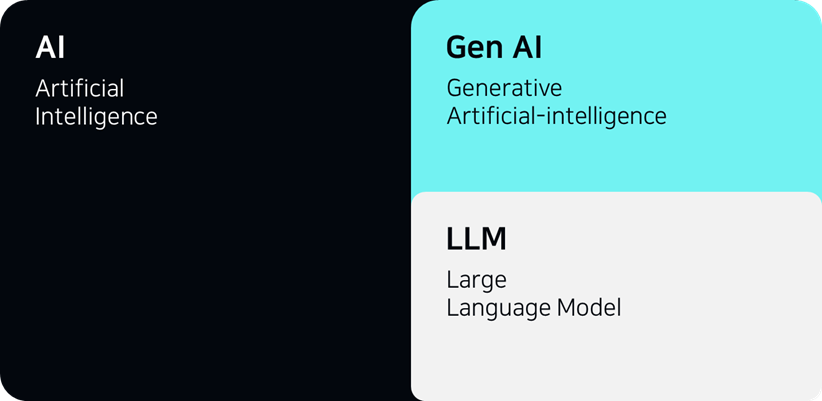

2. LLM vs AI / GEN AI

출처: 웅진ITAI – LLM - Gen AI의 개념 관계는 위와 같은 도식으로 정리할 수 있습니다.

AI는 최근에서야 주목받기 시작했지만, 1950년대부터 연구되기 시작한 기술 분야입니다.

AI는 이름 그대로, 사람의 지능(intelligence)를 가지고 있는 기계를 만드는데 목적을 두고 연구되었습니다.

AI 분야에서 빼놓을 수 없는 기술 중 하나가 바로 머신러닝(Machine Learning, ML)인데요.

머신러닝은 “인공 지능의 하위 범주로, 신경망을 활용하여 패턴을 인식하고 이러한 패턴 식별 역량을 개선하는 컴퓨터의 프로세스”를 의미합니다.

Gen AI는 바로 이 머신러닝 기술을 기반으로 개발되었습니다.

Gen AI는 학습한 데이터를 기반으로 새로운 데이터를 생성할 수 있는 알고리즘입니다.

LLM은 이러한 Gen AI의 하위 집합이라고 볼 수 있는데요.

기능적으로 보았을 때, “데이터를 학습하고 새로운 데이터를 생성”할 수 있다는 점에서 Gen AI와 동일해 보이지만, LLM은 기본적으로 문자(텍스트) 데이터에 기반한다는 점에서 Gen AI의 한 가지 유형으로 종속됩니다.

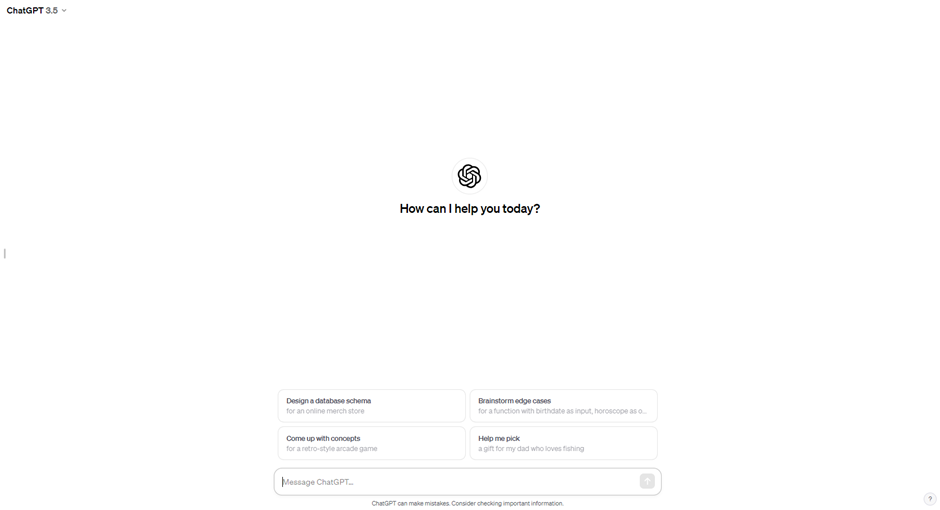

출처: ChatGPT 캡처OpenAI사의 ChatGPT는 LLM을 활용한 대표적인 AI 툴로 소개되는데요.

현재 (24년 1월) 무료로 이용 가능한 GPT-3.5는, 모든 입력과 출력이 텍스트를 기반으로 이루어지고 있다는 점을 확인할 수 있습니다.

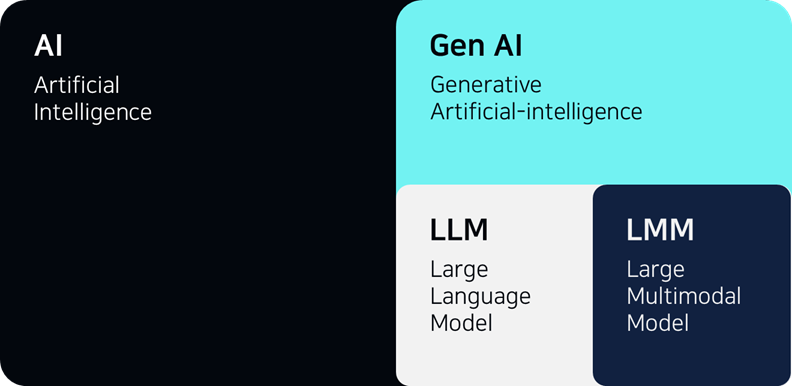

3. 떠오르는 대세: LMM

2022년 말, OpenAI의 ChatGPT 서비스가 무료로 공개되면서 LLM의 시대를 열었다면, 최근에는 “멀티모달(multimodal)”에 대한 관심이 높아지고 있습니다.

출처: 웅진IT멀티모달모델은 LMM(Large Multimodal Model, 대형멀티모달모델)으로 불리며, 오디오, 이미지와 같이 텍스트가 아닌 형식의 데이터를 입력 받고 또 출력할 수 있다는 점에서 기존의 LLM과 차이가 있는데요. OpenAI 작년 3월 LMM에 해당하는 GPT-4를 공개하고, 유료 구독자들에게만 서비스를 제공하고 있습니다.

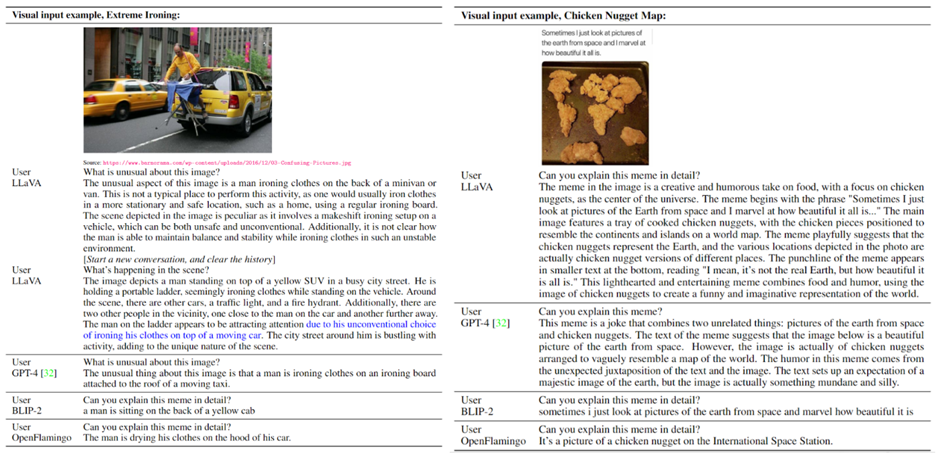

출처: LLaVA 홈페이지 캡처GPT-4에 이어 관심을 받고 있는 LLaVA (Large Language and Vision Assistant)는 이미지를 입력받았을 때, 단순히 대상을 인식하고 구분하는 것을 넘어서 사진 속 맥락을 파악하는데도 뛰어난 역량을 보여줍니다.

사진 속 사례를 보면, “차 뒤에 매달려 다리미질을 하고 있는 남성의 사진”을 입력하고, “사진 속 이상한 점”을 물었을 때, LLaVA는 “일반적으로 다리미질을 하는 장소가 어디인지” 예를 들어가며 상세히 답변합니다. “치킨으로 만든 세계지도와 함께 업로드 된 밈”에 대해 설명을 요청했을 때에도 LLaVA는 밈 속 텍스트와 사진의 부조화를 인식하며, 어떤 점에서 웃음을 자아내는지 정확히 설명하고 있습니다.

|

Outro

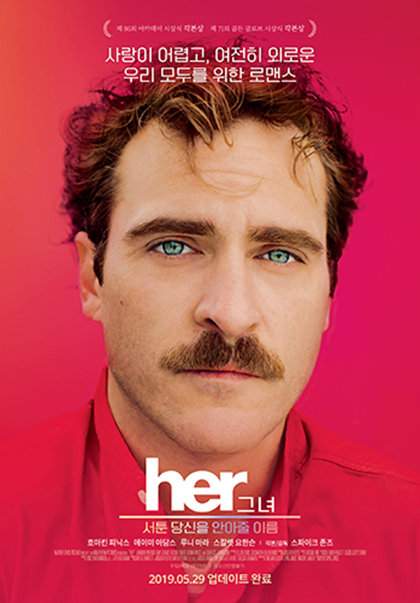

출처: 위키백과영화 Her은 2025년을 배경으로 인공지능 서비스와 사랑에 빠진 남성의 이야기를 그린 영화로 아카데미에서 수상하기도 했는데요. 영화 속에 등장하는 인공지능은 주인공 테오도르와 감정을 공유하고 ‘인간다운’ 관계를 맺습니다.

2025년을 1년 남겨놓은 지금, 데이터 유형의 제한 없이 학습하고 발전하는 인공지능이 정말로 인간과 같은 인격을 가지는 수준으로 발전할 수 있을지 주목됩니다.

Reference

Elizabeth Bell, “Generative AI vs. Large Language Models (LLMs): What's the Difference?” (2023.12.21)

https://appian.com/blog/acp/process-automation/generative-ai-vs-large-language-models.html

Nicholas Cropp, “So Whats The Difference Between AI, GAI, ML, LLM, GANs, and GPTs?”

https://www.linkedin.com/pulse/so-whats-difference-between-ai-gai-ml-llm-gans-gpts-nicholas-cropp/

임대준 기자, AI타임스, “LLM은 옛말...이미지까지 학습한 'LMM' 뜬다” (23.10.12)

https://www.aitimes.com/news/articleView.html?idxno=154291